Güven Güzeldere

Yapay Zekâ, son bir kaç yıldır bir Rönesans dönemine girdi. Çok hızlı gelişmeler oluyor. Niye böyle? Bu yeni paradigmanın temel unsurları neler?

Satrançta Deep Blue’nun 1997’de Kasparov’u yenmesi bir kilometre taşıydı. Fakat 2017’de Ke Jie’yi yenen AlphaGo, Deep Blue’nun onyıllarca yapamayacağı bir işi becerdi. Nasıl? AlphaGo gibi 2017 Yapay Zeka sistemlerinin, Deep Blue gibi 1997 sistemlerinden temel bir farkı mı var? Aradaki 20 senede neler değişti?

İlginç sorularla karşı karşıyayız. Çünkü bu arada matematik modelleme alanında çığır açıcı yenilikler oldu denemez. Yapay Zekâ başarısını neye borçlu? Üstelik, yeni Yapay Zekâ modellerinin matematiksel altyapısı nispeten basit. Ama sonuçlar çok etkileyici. Peki, bu başarı niye daha önce elde edilemedi?

Yapay Zekâ’nın geleceğini anlamak için, bugününe nasıl ulaştığını ve yeni paradigmada en temelde nelerin değiştiğini anlamaya çalışalım.

Önceki haftalarda söz ettiğimiz gibi, Alan Turing’le başlayan ve ABD’de Dartmouth Konferansı’yla devam eden klasik Yapay Zekâ paradigmasında ‘hesaplama mimarisi’, düşünce/dil yapısını yansıtan kurallar (önermeler) üzerine kuruluydu.

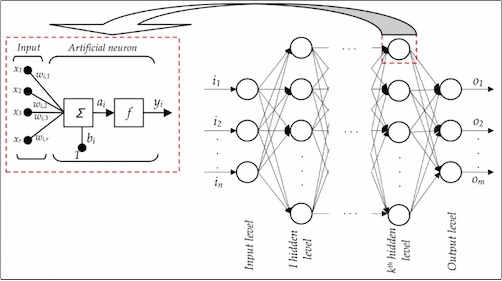

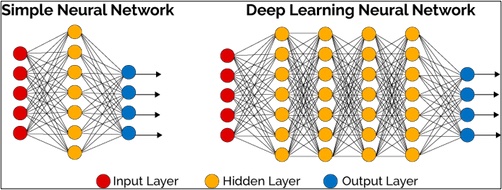

Bugün “Derin Öğrenme” yöntemiyle büyük ilerlemeler kaydeden Yapay Zekâ, “beyin tarzında hesaplama” diye niteleyebileğimiz bambaşka bir yöntem kullanıyor.

Dikkate değer bir nokta: “Beyin tarzında hesaplama” düşüncesi, aslında klasik Yapay Zekâ paradigmasından da önceye giden bir tarihçeye sahip. 1943’de kendisine ancak ”Matematiksel Biyofizik” dergisinde yer bulabilen şu makaleye bakalım: Sinir sistemine içkin izlenimlerin mantıksal hesabı.

Yolları daha sonra MIT’de kesişen bir nörobilimci Warren McCulloch ile bir mantıkçı Walter Pitts’in makalesi, gerçek bir öncü disiplinlerarası anlayışla yazılmış.

Makalenin ana tezi şu: Nöronlar, iki değerli (açık/kapalı) devreler gibi çalışmaları nedeniyle, önermeler mantığı sistemiyle modellenebilir. Yani McCulloch ve Pitts, 1943’de, henüz bilgisayarlar ortada yokken, beynin bir hesaplama makinası olarak modellenebileceğini, tamamen kuramsal olarak öne sürüyorlar.

Bu düşüncenin ters-yüz edilmiş hali, yani bilgisayarların beyin tarzında bir hesaplama yöntemi kullanabileceği fikri, bir süre unutulup, sonra “Yapay Nöron Şebekeleri” adıyla yeniden ortaya çıkacak ve bugünkü “Derin Öğrenme” modellerinin de temelini oluşturacaktır.

Bir dipnot: Burada bilim tarihine dair ilginç noktalar var. “Beyin tarzında hesaplama”modelleri, 1960larda Klasik Yapay Zekâ araştırmaları ile kıyasıya bir fon desteği rekabetine giriyor. Klasik Yapay Zekâ’nın önde gelen isimlerinden Marvin Minsky’nin “beyin tarzında hesaplama” modellerinin kısıtlamalarını göstermek üzere bir kitap yazması, her ne kadar aslında çok önemli sonuçlar içermese de, karşı cepheye büyük bir darbe vuruyor. Minsky’nin kitabının, ”perceptron”modelini geliştirirken fon desteğini kaybederek araştırmaları sona eren ve genç yaşta ölen Frank Rosenblatt’a adanmış olmasıysa, ayrı bir ironi.

Klasik Yapay Zekâ tarafından büyük ölçüde siyasi/maddi nedenlerle önü kesilen “beyin tarzında hesaplama” modelleri 1980lerde, bu kez bilişsel psikologlar sayesinde, yeniden canlandırılıyor.

“Paralel Dağıtılmış İşlemleme”, daha sonra “Yapay Nöron Şebekeleri” adıyla da anılıyor. Hepsinin temelindeyse, ”beyin tarzında hesaplama” var.

Yapay Nöron Şebekesi modelleri belli bir heyecan dalgası yaratsa da, başarılı sonuçları az sayıda kalınca, 2. kez yeniden rafa kaldırılıyor. “Beyin tarzında hesaplama”nın ikinci kez başarısızlığının ardında ne var sorusuna geleceğiz, ama önce başarılarına kısaca bakalım. Örneğin, şunu dinleyelim:

NETtalk benzeri Yapay Nöron Şebekesi modellemeleri 1980lerde özellikle dil konusunda heyecan yarattılarsa da, zamanla büyük ölçüde gündemden düştüler. Burada, başta sorduğumuz soruya geri dönüyoruz: Bugün Yapay Zekâ’nın derin öğrenme modellerinin sağladığı başarı niçin daha eskiden gerçekleşemedi?

Günümüzde derin öğrenme ile elde edilen başarılı sonuçlar, olağanüstü yeni matematiksel buluşlar sayesinde olmadı. Anahtar yeni modeller değil, veri. 1980lerde ortada olmayan ama şimdi Yapay Zekâ’nın elinde olan, ‘veri madenciliği’ni mümkün kılan ve her alanda erişilebilmesi kolay, kullanılmaya hazır ‘büyük veri’ kümeleri.

GO maçlarından Oscar ödüllerine, radyoloji taramalarından seçim sonuçlarına kadar müthiş sayıda veri öbeği, artık Yapay Zekâ modellerince kullanılabiliyor. Klasik Yapay Zekâ modellerine göre büyük veri içinde hızla örüntüler saptayıp kullanabilen, kendini geliştiren programlar Yapay Zekâ’nın geleceğinin de nüvesini oluşturuyor.

Peki, bu arkaplan ışığında, Yapay Zekâ’nın geleceği hakkında ne söyleyebiliriz? Hızla değişen dünyamızda bizi YZ kaynaklı ne tür sorunlar bekliyor?

Önce, Yapay Zekâ’nın uygulamaya konduğu alanları ikiye ayıralım: Kural ve sınırları belli kapalı alanlar (“micro domains”) ve ucu açık alanlar.

Satranç oyunu, ideal bir kapalı alan. Başı, sonu, kuralları kendi içinde tanımlanmış. Bir YZ satranç sisteminin oyunu iyi oynaması için, satrançla alakalı olmayan başka hiç bir bilgiye ihtiyacı yok.

Öte yandan, insanların (ve genel olarak canlıların) hayatının, ucu açık bir doğası var. Her şey bilinen kurallara bağlı değil ve olağanüstü çok sayıda değişken var.

Yapay Zekâ tarihsel olarak kapalı-alanlarda büyük başarılar gösterdi. Kuralları belli olmayan, otonom anlayış ve davranış gereken ucu açık alanlarda hep zorlandı. Bu sebeple, radyologlara destek olacak, tarama görüntülerinden tümör saptayan bir sistemin yaygın kullanımına çok yakınız. Otonom Yapay Zekâ doktorlarıysa hâlâ çok uzağımızda.

Birkaç hafta önce sorduğumuz bir başka sorunun da cevabını şimdi verebiliriz: Yapay Zekâ hangi sanat dallarında daha başarılı sonuçlar veriyor? Niye?

Öte yandan, insan yazardan ayırt edilemeyen bir romancı Yapay Zekâ sistemi yok. Roman yazmak Yapay Zekâ sistemleri için müzik bestelemekten çok daha zor.

Bu, müziğin romana oranla eksikliğinden değil. Yalnızca müziğin ve müzik besteciliğinin, bütün duygusal etkileme gücüne karşın, kuralları belli bir tür ‘kapalı alan’ olmasından kaynaklanıyor.

Romanın alanı ise çok daha açık. Şiir ve resmin, temsil tarzları dolayısıyla belki bu ikisinin ortalarında bir yerlerde olduğunu da söyleyebiliriz. Bu görüşüme katılmayanlar çıkabilir. Ama burada asıl dikkat çekmek istediğim, Yapay Zekâ’nın son zamanlarda giderek daha ucu açık, otonomi gerektiren alanlara da el atıyor olması.

Yeri gelmişken, Yapay Zekâ’nın otonom sistemler geliştirmedeki başarısızlığından kaynaklanan bir “öngörülemeyen sonuçlar” tarihsel dipnotu düşeyim: Yapay Zekâ projesinin erken dönemde büyük hedefi, ucu açık alanlarda insanın yerini tutabilecek otonom uzman sistemler, robot doktorlar, avukatlar, askerler geliştirmekti. Fakat biyolojik hayat çok karmaşık. Algılama ve düşünmenin yanı sıra ucu açık, sınırları belirsiz fiziksel doğada hareket etmek, enerji üretmek ve harcamak, ekolojik bir çevre kurmak ve hayatta kalmak, çok zor işler.

Kendi başlarına, otonomiyle hareket edebilen çok basit canlılara, karıncalara, sineklere benzeyen robot sistemler bile ancak bugünlerde tasarım ve gelışme aşamasında.

Ucu açık alanlarda Yapay Zekâ’nın tökezleyeceğinin öngörülememesi, ilk zamanlarda boş vaatlere, yanlış tahminlere ve 1980lerde ortaya çıkan ”Yapay Zekâ Kışı”na yol açtı. O dönemde Yapay Zekâ’nın başarısızlıkları sonucunda fonların kurumasıyla, alan büyük bir çöküş yaşadı. Laboratuvarlar kapandı, projeler terk edildi, insanlar işsiz kaldı.

Fakat ‘Yapay Zekâ Kışı’nın öngörülemeyen olumlu bir sonucu da oldu. İnsan-makina etkileşimi (“human-computer interaction”) diye yeni bir alan, eski Yapay Zekâ araştırmacılarının önemli katkılarıyla doğdu. Yapay Zekâ araştırmalarını terk etmek zorunda kalan Terry Winograd gibi bilgisayar biliminin önemli isimleri, ilgilerini etkileşim alanına kaydırdılar. İnsan-bilgisayar etkileşimi araştırmalarıysa, daha etkili kullanıcı arayüzlerinin tasarlanmasına ve ‘akıllı yardımcılar’ın doğmasına yol açtı. ‘Akıllı yardımcı’lardan kastım, otonom olması gerekmeyen, yalnızca insan kullanıcıya asist etme işlevini üstlenen, bilgisayar sistemleri.

Bu uzun dipnotu böylece bitireyim. Otonom doktorlar gibi erken Yapay Zekâ hedeflerinden, iPhone’larda yer alan Siri gibi uygulamalara uzanan yolun hikâyesi özetle böyle.

‘Akıllı Yardımcı’lara güzel bir yeni örnek: Görmezlere çevreyi tasvir eden, önündeki nesneleri tanıyan, metinleri okuyan, “Seeing AI” uygulaması.

‘Akıllı Yardımcılar’ alanında Yapay Zekâ’da büyük gelişmelere kendi yaşamlarımızda şahit olacağımızı düşünüyorum.

Peki otonom sistemlerde durum ne? Yapay Zekâ’da otonom sistemler geliştirmek geriden gelse de artık orada da yenilikler var, ama maalesef, büyük ölçüde savaşa yönelik askeri alanlar başı çekiyor. ABD’de askeri fonlarla desteklenmiş Boston Dynamics şirketinin geliştirdiği otonom ‘yaratık’lara daha önceki programlarda değinmiştik. Bir ürperti hissi olmadan izlemek mümkün değil: Introducing Spot

t24 haber sitesinde Metin Gürcan, askeri alanda robotik araştırmaların geleceğine dair önemli meseleleri Robot çağı jeopolitiği ve robotik askeri devrim başlıklı yazısında ele almış.

Sivil hayatta, otonom Yapay Zekâ konusunda en hızlı gelişme gösteren alansa insansız hava araçları İHA’larla da yakından ilintili olan sürücüsüz otomobiller.

Artık bu alana kar amacıyla Google gibi şirketler de el atmış olsa da, ‘sürücüsüz otomobiller’epey eskiden beri MIT gibi üniversitelerde araştırılıyor ve prototip araçlar geliştiriliyordu.

Sürücüsüz otomobiller alanında en büyük zorluk, Yapay Zekâ sistemlerinin insan sürücülerin davranışlarını yeterince modelleyememeleri. İnsan sürücüleri olmayan bir trafik mümkün olsa, sürücüsüz araçlar çok kısa zamanda uygulamaya konacak gelişmeyi kaydetmiş durumda ve hazır.

İnsan sürücüler, trafiği Yapay Zekâ sistemleri için bir açık alan haline getiriyor. Tamamı sürücüsüz vasıtalı bir trafik ise nispeten bir kapalı alan olurdu. Nispeten diyorum, çünkü yola fırlayacak bir yaya, -özellikle ülkemizde- her zaman bulunur.

Askeri alanda olduğu gibi sivil hayatta da otonom Yapay Zekâ sistemleriyle ilgili bir dizi hukuki ve etik sorun yakın gelecekte karşımızda olacak.

Yapay Zekâ ve otonom robotik alanındaki etik sorular için şimdiden akademik kongreler düzenleniyor, kitaplar yayımlanıyor, tartışmalar dünya gündeminde yer buluyor.

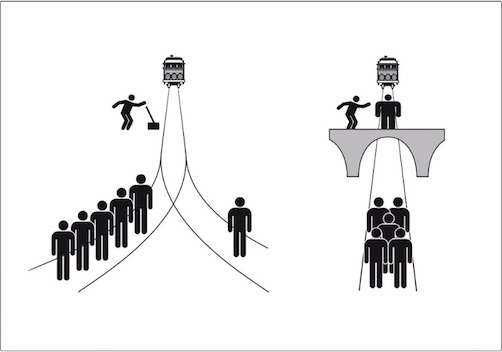

Örneğin, sürücüsüz araçlar, bir kaza durumunda, her zaman en az sayıda insanın zarar göreceği şekilde mi programlanmalı? Peki ya kaza anında en az sayıda insanın zarar görmesi, aracın içindeki kişinin ölmesini gerektirirse? Siz böyle bir araca biner miydiniz?

‘Troleybüs Açmazı’nı biz de 3 program boyunca detaylıca tartışmıştık:

Yapay Zekâ’nın gelişmesiyle, ciddi sorunlarla yakın gelecekte karşı karşıya kalacağımız açık. Etik ve hukuki sorulara şimdiden eğilmek gerekiyor. Geçen haftaki programda Prof. Cem Say’ın dediği gibi,Yapay Zekâ sistemlerinin geleceğine bizler şekil vereceğiz, bunu ‘çocuk yetiştirir gibi’ özenle yapmamız gerekiyor.

Tam bu sebeple, teknoloji önden gitsin, işin felsefesi, hukuku, etik tartışmaları arkadan nasılsa yetişir demek, büyük bir hata olur. Bu vesileyle, Yapay Zeka’nın insanlık tarihindeki en büyük çokdisiplinli proje olduğunu, yalnızca bir teknoloji ve mühendislik projesi olarak görülmemesi gerektiğininin altını bir kez daha çizelim.

Bu uzun “Yapay Zeka’nın Geleceği” tefrikasını, ülkemizin eğitim, bilim, ve teknolojideki yerini ele alarak bitirmek isterim.

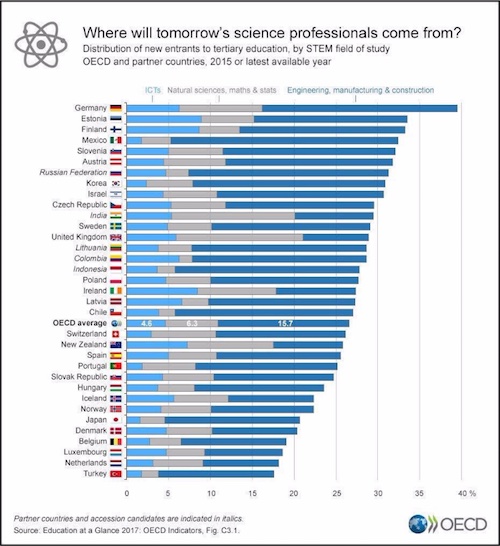

Durumumuz maalesef hiç iç açıcı değil. Yeni bir 2017 OECD çalışması, “Bilim ve teknolojinin yarınında söz sahibi olacak insanlar, hangi ülkelerden çıkacak?” diye sormuş. 30+ ülke arasında neredeyiz? En son sıradayız!

Yapay Zekâ kendi başına bizim sorunlarımıza çare değil. Önce bilimi hakkıyla yapacak, teknoloji geliştirecek, iyi eğitimli insanlar yetiştirmemiz gerekiyor.